我尝试将hanlp部署成web服务,并且使用GPU

_client = None

def get_client():

global _client

if _client is None:

import hanlp

_client = hanlp.load(hanlp.pretrained.mtl.OPEN_TOK_POS_NER_SRL_DEP_SDP_CON_ELECTRA_BASE_ZH)

其他模块通过get_client()获取hanlp实例,这样可以避免反复重新load模型。

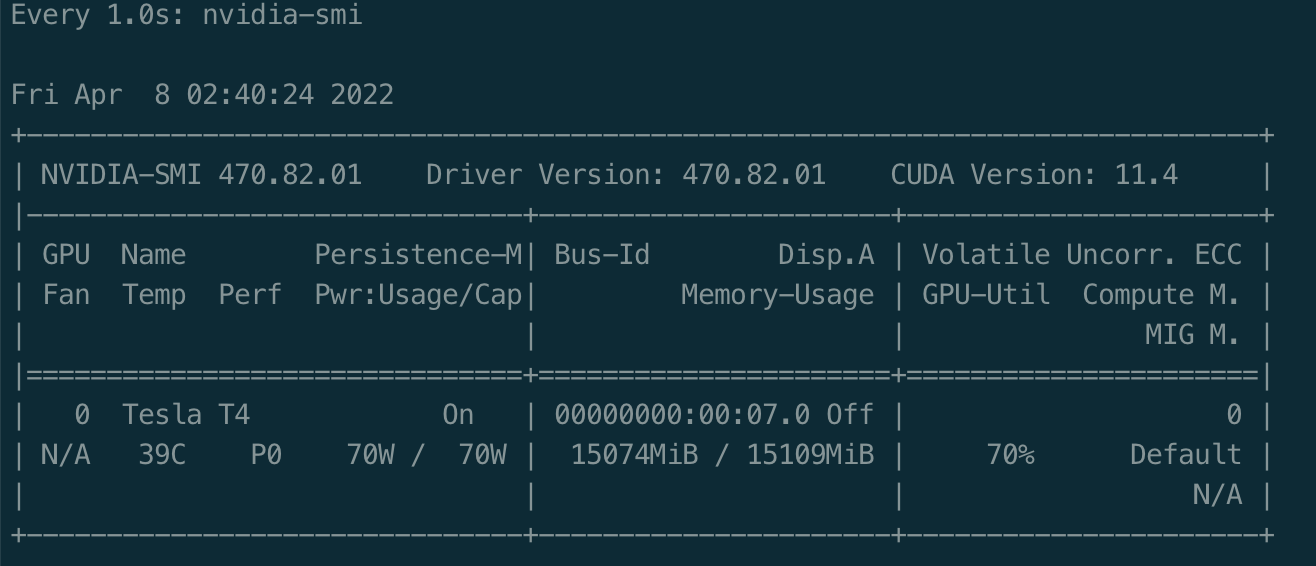

但是在测试中发现,显存会逐渐增加,最后CUDA out of memory

请问这种情况应该怎么解决?